Die robots.txt ist eine Textdatei auf einer Webseite, die von Webcrawlern oder Suchmaschinen-Robotern genutzt wird, um Anweisungen für das Crawlen und Indexieren von Inhalten auf der Webseite zu erhalten.

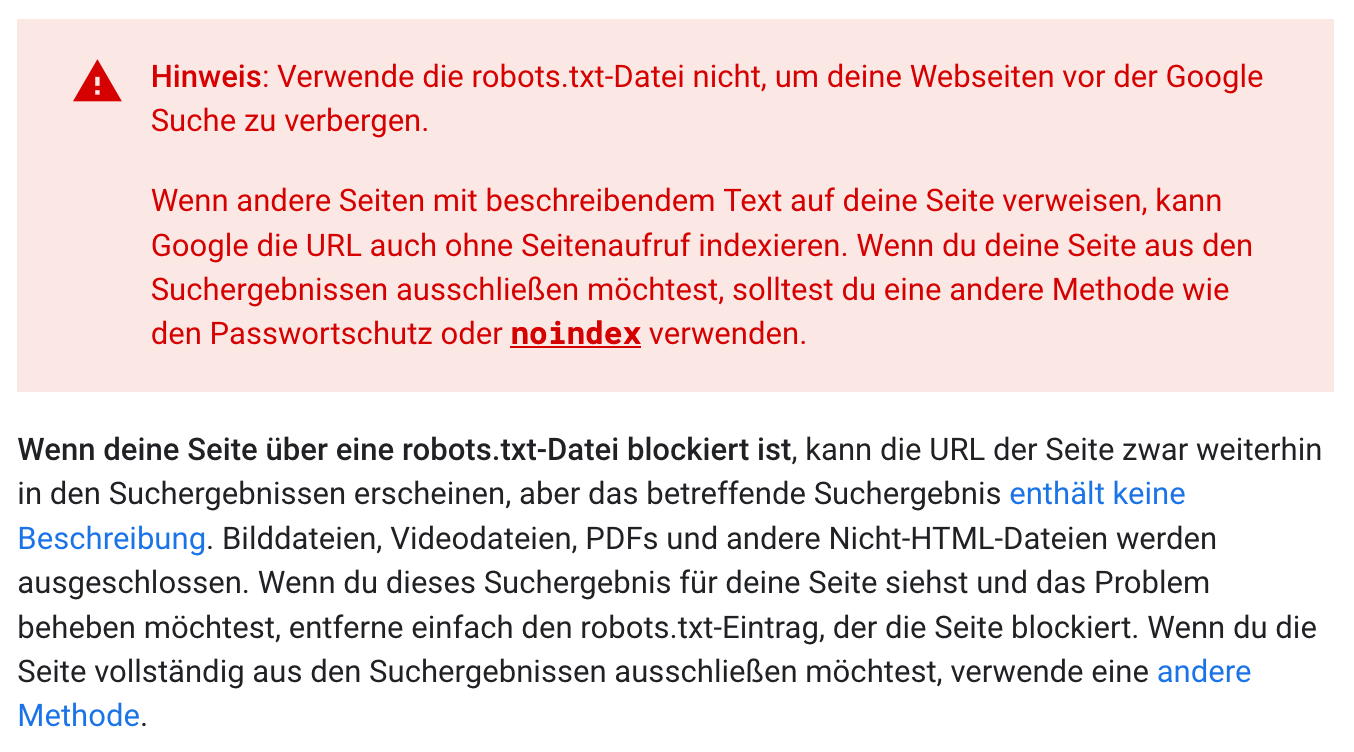

Sie ist eine wichtige Komponente im Bereich des Online-Marketings und der Suchmaschinenoptimierung (SEO). Die robots.txt ermöglicht Webseitenbetreibern die Kontrolle darüber, welche Teile ihrer Webseite von Suchmaschinen-Robotern durchsucht werden dürfen und welche nicht.